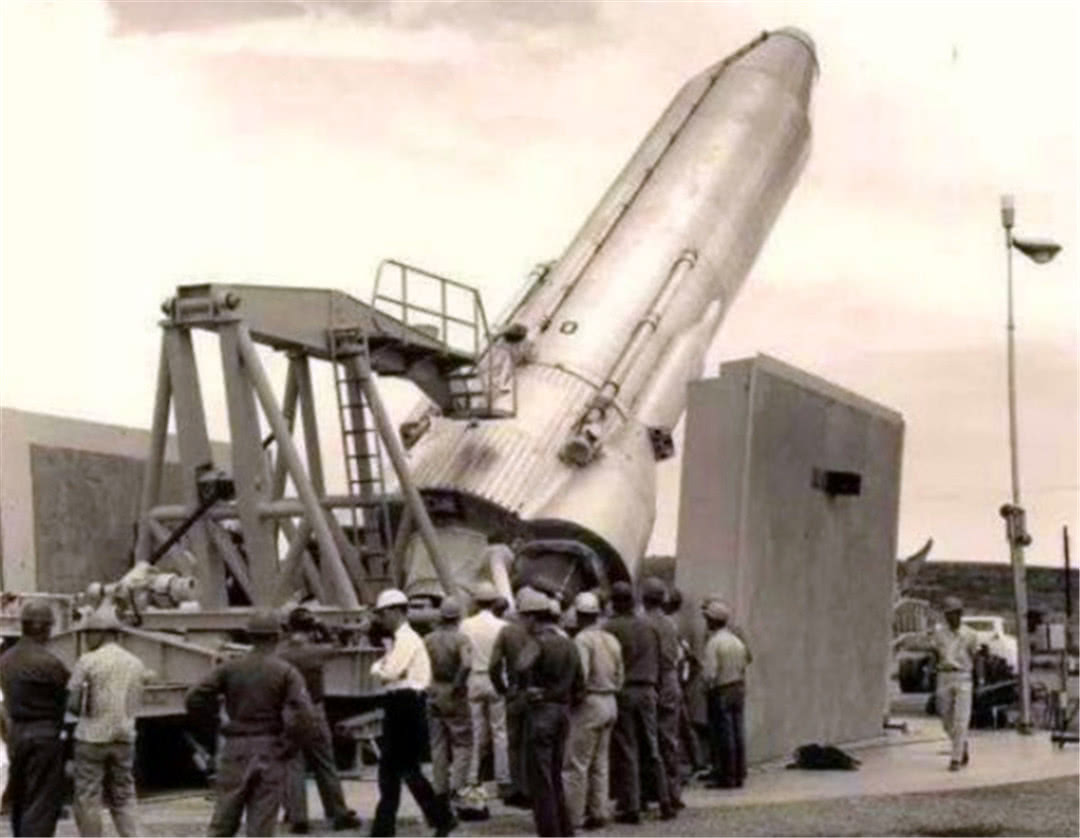

图片来源:美国空军

美国军队几乎每天都需要在世界各地的战区提供火力支援。通过向远处的榴弹炮发射坐标,步兵可以向敌军发射毁灭性的 155 毫米炮弹。如果美国国防部的计划不足为奇,人工智能将加快这一进程。

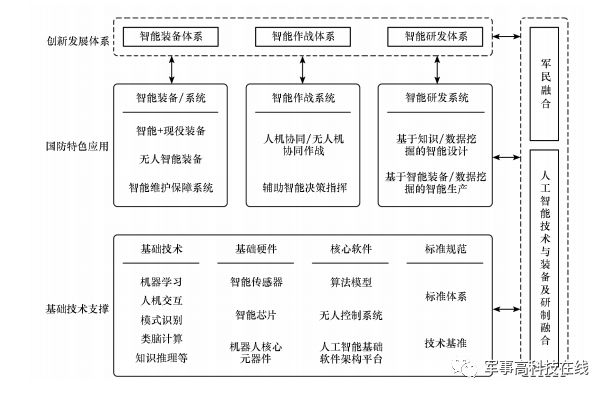

沙纳汉中将使用“加速火力支援”这一简单(后果较低的任务)作为五角大楼展示将人工智能整合到其武器系统中的优势。作为国防部 140 人联合人工智能中心的负责人,Shanahan 和他的团队正在加速前沿 AI 技术的应用,例如预测性维护和健康状态分析工具,以及新兴实施到美国的核心战斗力。

Shanahan 预计 AI 将提高美军完成任务的速度。过去,相关情报是通过人眼分析,例如盯着屏幕识别和跟踪目标,然后交给计算机执行任务。现在可能由军官来决定最合适的武器选择,但沙纳汉在接受采访时说,“20 年后,计算机可以像人类一样快速地推荐最好的武器。” 跟踪战场状况的指挥和控制系统将整合为一体。

未来智能战士(狙击手)

杀手机器人判断目标的生死并不难。最厉害的是它具备军用版等智能定位能力(Waze,谷歌开发的GPS定位系统)。正如沙纳汉所说,“尽可能让机器相互交流,关键时刻由人类做出决策。”

但是这个计划真的很难实施。即使收集了大量可用于构建图像识别和决策算法的数据,所使用的算法也仅适用于该组数据应用程序。

其他人则认为,应该如何管理军用 AI 系统以使其不会被滥用人工智能战争:舰队指挥官,例如使用计算机来判断狙击敌人是否太过分。计算机有攻击的权力,但权责等相关规定不明确。

“当机器取代人类控制时,它只会提出责任问题,”美国国防分析师兼即将出版的科技惊悚片 Burn-In 的合著者彼得辛格说。

“二十年后,我们正在研究算法与算法。” ——联合人工智能中心负责人Shanahan

面对与五角大楼的人工智能技术合作,这些伦理争议使硅谷产生了很大的分歧。在领导联合人工智能中心之前,Shanahan 领导了 Maven 项目,这是一个图像识别项目,旨在使用大量空中监视镜头自动检测敌军。面对员工的强烈反对,谷歌于 2018 年退出了该项目。但这并没有阻止该计划向前发展。《商业内幕》报道称,Peter Thiel 的数据分析公司 Palantir 已签约接管该计划的实施。

五角大楼在人工智能方面的微薄支出(预计 2020 年约为 40 亿美元)使得任何科技巨头都不太可能长期合作。尽管退出了 Maven,谷歌高管仍表示愿意继续与五角大楼合作。“我们渴望做得更多,”谷歌高级副总裁肯特沃克在国家安全委员会人工智能会议上说。与此同时,亚马逊总裁杰夫·贝佐斯 (Jeff Bezos) 积极地将亚马逊定位为不怕与军队抗衡的公司。合作厂商。贝索斯甚至在里根国防论坛上表示,如果大型科技公司不支持国防部,国家就会陷入困境。

贝索斯如此公开地支持五角大楼,因为他正在与微软竞争 100 亿美元的云计算合作伙伴关系,即 JEDI(联合企业防御基础设施。该系统是 Shanahan 的人工智能野心的核心,提供计算能力和共享基础设施),以处理大型数据集和统一不同的系统。)

Maven项目实施时,正是因为缺少这样的云系统,无法数字化获取所需的监控视频,只好派下属去取。“有时我们真的需要派卡车到处收集全动态录像带,但有了云支持,这真的容易多了,”Shanahan 说。

没有云支持,系统更新比较麻烦。还必须派人到不同的军事点来实际安装较新的版本。如今,Maven 每月左右自动更新系统,这对于政府效率来说是快的,但在沙纳汉还不够快。

尽管如此,JEDI 无法解决 Shanahan 的所有问题,因为需要克服数据质量问题。以 JAIC 项目之一为例人工智能战争:舰队指挥官,该项目是军方无处不在的 UH-60 黑鹰直升机的预测性维护工具,专注于确定关键部件何时会损坏。当他们开始从各个分支机构收集数据时,沙纳汉的团队发现陆军的黑鹰配备的版本与特种作战司令部使用的版本略有不同,导致同一台机器产生不同的数据。

“在任何情况下,数据都不会达到你想要的质量,即使是这样,我也无法获得他的原始数据,”他说。

数据质量将成为军事人工智能盲点的主要来源。计算机永远不会知道它不知道什么。宾夕法尼亚大学教授迈克尔霍洛维茨提到,“根据历史数据开发的算法可能面临与实际战场不同的困境。”

例如,Shanahan 反驳说,为了预测发动机叶片断裂的时刻,严格的测试和评估过程可以降低这种风险。但实际上,如果AI面对前所未有的战争射击规模和速度,它真的能应付吗?

当不可预测的计算机逻辑运算与人脑联合起来时,就会出现棘手的问题。计算机的判断可能会令人困惑,但使用它的人必须决定是否信任计算机。当谷歌的 AlphaGo 击败 2016 年世界围棋冠军李世石时,李有一次从椅子上站起来离开了房间,因为他的电脑对手玩了一场连李世石都感到困惑的游戏。一位观察家谈到这一举动时说:“我从未见过有人这样做,太棒了!”

想象一下,如果高风险冲突中的武器系统给人类指挥官带来同样难以理解的行动会怎样?目前,这是美军正在积极尝试解决的问题。国防高级研究计划局正在开发一个提出“可解释的人工智能”的计划,旨在将机器学习系统的黑匣子变成一个可以为其决策提供信息的系统。

Shanahan 指出,为了建立这种信任,指挥官需要尽早提高他们的技术知识。使用图像识别和卫星图像来了解洪水和野火风险等项目是他的团队通过实践学习和积累专业知识的一种方式。在不了解技术或其潜力的情况下,说穿了只是阅读科幻小说。

不可避免地,在官僚体制下,沙纳汉仍然面临重重阻碍。五角大楼人工智能相关举措的报告,正如国会指定兰德公司所报告的那样,表明国防部缺乏评估进展的“基准和指标”,JAIC 在国防部整体系统中的作用仍不清楚,而且 JAIC 缺乏实现其目标的行政权力。此外,五角大楼的人工智能测试和验证机制因“未能充分确保人工智能应用程序的性能和安全性,特别是在涉及安全关键系统的情况下”而被评为差评。

不过,五角大楼在一份声明中接受了这份报告,因为它还强调了美国军方如何在改进技术的同时快速应对来自俄罗斯或中国的威胁。“国家之间的军事角力只会越来越快,20 年后我们将面临算法之间的战争,”Shanahan 说。

F22战斗机

面对威胁,美军更加重视自动化技术。美国陆军正在测试自动炮塔,空军正在开发无人机机翼。而海军的“幽灵舰队”概念正在研制无人水面舰艇。为了更快,五角大楼必须依靠计算机计算。

“坦率地说,我们必须问自己,一个软件系统必须有多准确才能被视为可接受的标准?” 前中央情报局分析师、新美国安全中心研究员拉瑟说。“假设人类在 99.99% 的情况下是正确的。但他们取代的软件系统是否需要相同的标准检查,还是更准确?”

在国防创新委员会的一份报告中,对五角大楼相关问题的讨论为军方如何在道德规范中采用人工智能提出了一套原则。Shanahan 想聘请一名伦理学家加入 JAIC,后者一直在关注关于军事人工智能的伦理辩论。他说他最初反对所谓的“杀手机器人”或所谓的“无人监督的、独立的目标系统,其中机器控制生死”。"

沙纳汉乐观地说,“人类在战场上每天都会犯错误。经过混乱,情绪高涨,害怕战友死亡。我在基地总是说,我们可以做很多事情来减少使用人工智能可能造成的错误。 . . ,但不可能完全没有错误。”